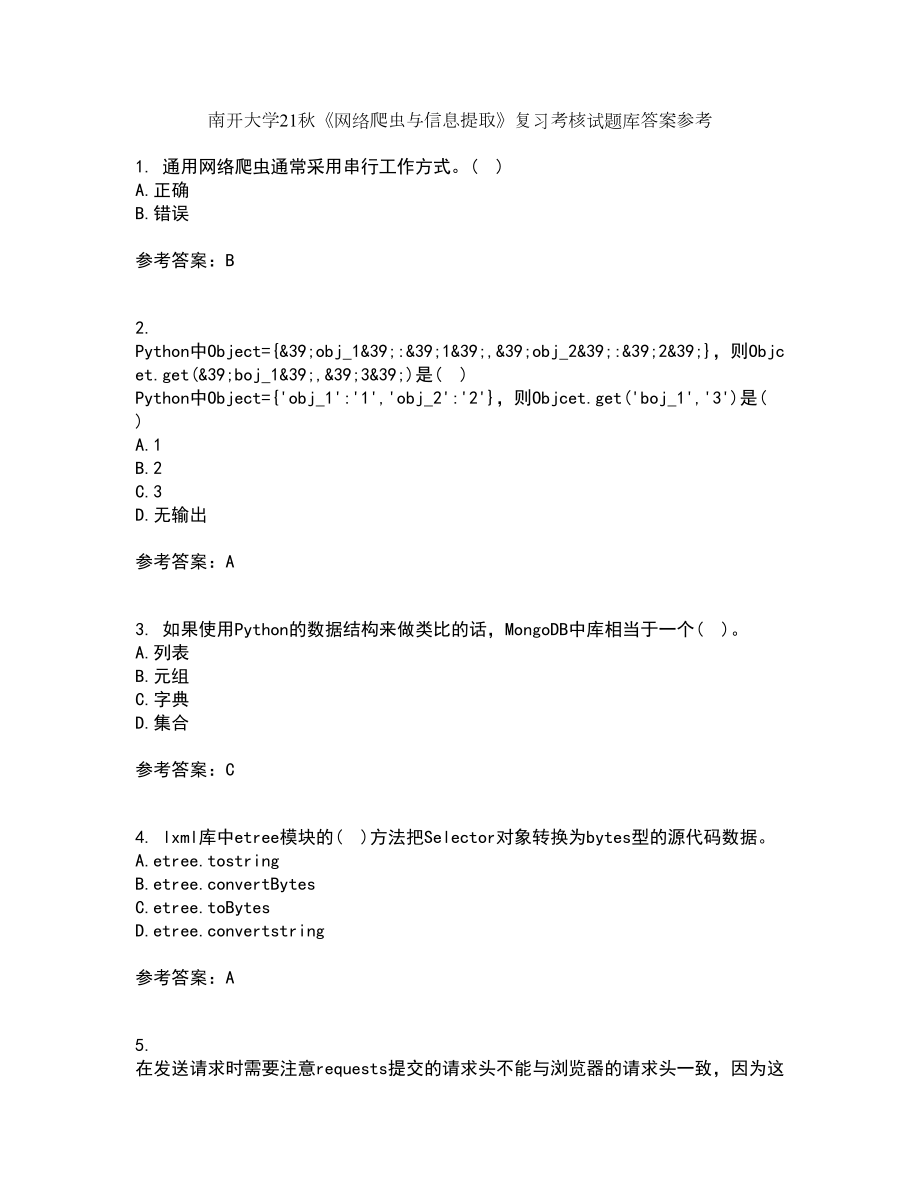

南开大学21秋《网络爬虫与信息提取》复习考核试题库答案参考套卷78

南开大学21秋《网络爬虫与信息提取》复习考核试题库答案参考1. 通用网络爬虫通常采用串行工作方式 )A.正确B.错误参考答案:B2. Python中Object={&39;obj_1&39;:&39;1&39;,&39;obj_2&39;:&39;2&39;},则Objcet.get(&39;boj_1&39;,&39;3&39;)是( )Python中Object={'obj_1':'1','obj_2':'2'},则Objcet.get('boj_1','3')是( )A.1B.2C.3D.无输出参考答案:A3. 如果使用Python的数据结构来做类比的话,MongoDB中库相当于一个( )A.列表B.元组C.字典D.集合参考答案:C4. lxml库中etree模块的( )方法把Selector对象转换为bytes型的源代码数据A.etree.tostringB.etree.convertBytesC.etree.toBytesD.etree.convertstring参考答案:A5. 在发送请求时需要注意requests提交的请求头不能与浏览器的请求头一致,因为这样才能隐藏好自己达到获取数据的目的。

)T.对F.错参考答案:F6. 自动填充验证码的方式有( )自动填充验证码的方式有( )A.手动识别填写B.图像识别C.打码网站D.浏览器自动识别参考答案:BC7. 要使用tesseract来进行图像识别,需要安装两个第三方库( )要使用tesseract来进行图像识别,需要安装两个第三方库( )A.requestsB.beautifulsoupC.PillowD.pytesseract参考答案:CD8. Python中直接对浮点数进行计算有print(0.1+0.2),则结果为0.3 )T.对F.错参考答案:F9. 为了保证数据插入效率,在内存允许的情况下,应该一次性把数据读入内存,尽量减少对MongoDB的读取操作 )T.对F.错参考答案:T10. Python中( )容器有推导式Python中( )容器有推导式A.列表B.元组C.字典D.集合参考答案:ACD11. cookies在http请求中是明文传输的 )cookies在http请求中是明文传输的 )A.正确B.错误参考答案:A12. Python正则表达式模块的findall方法提取内容包含多个,则返回结果的列表中会包含( )A.列表B.元组C.字典D.集合参考答案:B13. 插入数据时,MongoDB会自动添加一列“_id”,也就是自增ID,每次自动加1。

)插入数据时,MongoDB会自动添加一列“_id”,也就是自增ID,每次自动加1 )A.正确B.错误参考答案:B14. process_spider_output(response, result, output)是在下载器中间件处理完成后,马上要进入某个回调函数parse_xxx( )前调用 )process_spider_output(response, result, output)是在下载器中间件处理完成后,马上要进入某个回调函数parse_xxx( )前调用 )A.正确B.错误参考答案:B15. 为了在安卓手机上安装证书,需要先发送证书到手机里面在Charles中选择“Help”-“SSL Proxying”-“Save Charles Root Certificate”命令,可以将Charles的证书保存到计算机桌面 )T.对F.错参考答案:T16. 服务器端记录信息确定用户身份的数据是( )A.sessionB.cookiesC.moonpiesD.localstorage参考答案:A17. ( )是一个传递信息的通道它负责将爬取博文列表页获取到的信息传递给负责爬取正文页的方法中。

A.metaB.headC.headerD.body参考答案:A18. 在Scrapy的目录下,哪个文件负责存放爬虫文件?( )A.spiders文件夹B.item.pyC.pipeline.pyD.settings.py参考答案:A19. 可以通过( )绕过网站登录A.sessionB.cookiesC.moonpiesD.localstorage参考答案:B20. Python中有哪些实现多线程方法?( )A.multiprocess.dummyB.threading.ThreadC.processD.PyMongoDB参考答案:AB21. PyMongo中逻辑查询表示小于的符号是( )A.$gtB.$ltC.$gte$$lte参考答案:B22. MongoDB是一个关系数据库产品 )A.正确B.错误参考答案:B23. Selenium必须加载对应的webdriver才能模拟浏览器访问 )Selenium必须加载对应的webdriver才能模拟浏览器访问 )A.正确B.错误参考答案:A24. 下面关于Charles使用说法错误的是( )A.在数据包非常多的情况下,使用Charles的过滤功能来对数据包进行过滤从而减少干扰B.通过单击图中方框框住的各个选项卡,可以非常直观地观察到请求和返回的各种信息C.如果浏览器是Chrome,在没有安装第三方代理插件的情况下,Chrome的HTTP流量都会经过CharlesD.Charles无法支持计算机上除了浏览器之外的其他软件参考答案:D25. device.sleep( )方法是使用UI Automatorr关闭屏幕的命令。

)A.正确B.错误参考答案:A26. 要使用Python来操作UI Automator从而控制手机,需要安装一个第三方库( )A.uiautomatorB.automatorC.ui_automatorD.pyautomator参考答案:A27. 当Charles抓包以后,在Mac OS系统下可以按Command+F组合键,在Windows系统下按Ctrl+F组合键打开Charles进行搜索 )T.对F.错参考答案:T28. 下面Python代码输出为( ):def default_para_without_trap(para=[], value=0): if not para: p下面Python代码输出为( ):def default_para_without_trap(para=[], value=0): if not para: para = [] para.append(value) return para print('第一步:{}'.format(default_para_trap(value=100))) print('第二步:{}'.format(default_para_trap(value=50)))A.第一步:[100] 第二步:[100,50]B.第一步:[100] 第二步:[50]C.第一步:[100] 第二步:[]D.第一步:[100] 第二步:[100]参考答案:B29. 在Scrapy的目录下,哪个文件负责定义需要爬取的数据?( )A.spiders文件夹B.item.pyC.pipeline.pyD.settings.py参考答案:B30. Python中若定义object=[1, 2, 3, 4, 5],则print(object[:3])输出( )Python中若定义object=[1, 2, 3, 4, 5],则print(object[:3])输出( )A.12B.123C.23D.234参考答案:B31. Charles和Chrome开发者工具相比,只是多了一个搜索功能。

)T.对F.错参考答案:F32. 在安装Scarpy的依赖库时,由于Visual C++ Build Tools的安装速度很慢,为了节省时间,可以和安装Twisted同时进行 )T.对F.错参考答案:F33. PyMongo中的查找方法的参数是哪种数据结构( )A.列表B.元组C.字典D.集合参考答案:C34. 如果目标网站有反爬虫声明,那么对方在被爬虫爬取以后,可以根据( )来起诉使用爬虫的公司A.服务器日志B.数据库日志记录C.程序日志记录D.服务器监控参考答案:ABCD35. MongoDB中可以将( )数据结构插入集合中A.列表B.元组C.字典D.集合参考答案:C36. 下面Python代码输出为( ):def default_para_trap(para=[], value=0):para.append(value)return下面Python代码输出为( ):def default_para_trap(para=[], value=0):para.append(value)return paraprint('第一步:{}'.format(default_para_trap(value=100)))print('第二步:{}'.format(default_para_trap(value=50)))A.第一步:[100]第二步:[100,50]B.第一步:[100]第二步:[50]C.第一步:[100]第二步:[]D.第一步:[100]第二步:[100]参考答案:A37. Scrapy作为一个爬虫的框架,它在单机环境下运行时就可以获得最大性能优势。

)Scrapy作为一个爬虫的框架,它在单机环境下运行时就可以获得最大性能优势 )A.正确B.错误参考答案:B38. 使用UI Automatorr让屏幕向右滚动的操作是得到相应控件后使用命令scroll.horiz.forward( ) )T.对F.错参考答案:F39. process_spider_input(response,spider)是在爬虫运行yield item或者yield scrapy.Request( )的时候调用 )A.正确B.错误参考答案:B40. charles配置中,安装完成证书以后,在设置中打开“关于本机”,找到最下面的“证书信任设置”,并在里面启动对Charles证书的完全信任 )charles配置中,安装完成证书以后,在设置中打开“关于本机”,找到最下面的“证书信任设置”,并在里面启动对Charles证书的完全信任 )A.正确B.错误参考答案:A41. Robo 3T与RoboMongo是完全不一样的软件 )Robo 3T与RoboMongo是完全不一样的软件 )A.正确B.错误参考答案:B42. 如果通过爬虫抓取某公司网站的公开数据,分析以后发现这个公司业绩非常好,于是买入该公司股票并赚了一笔钱。

这是合法的 )如果通过爬虫抓取某公司网站的公开数据,分析以后发现这个公司业绩非常好,于是买入该公司股票并赚了一笔钱这是合法的 )A.正确B.错误参考答案:A43. 引用中间件时后面的数字代表的是中间件的执行顺序,例如 &39;AdvanceSpider.middlewares.ProxyMiddleware&39;: 543中的543 )T.对F.错参考答案:T44. 如果爬虫爬取的是商业网站,并且目标网站使用了反爬虫机制,那么强行突破反爬虫机制可能构成( )A.非法侵入计算机系统罪B.非法获取计算机信息系统数据罪C.非法获取计算机数据罪D.非法获取系统罪参考答案:AB45. PyMongo删除操作有( )PyMongo删除操作有( )A.deleteB.delete_allC.delete_oneD.delete_many参考答案:CD46. Python中若定义object=“12345”,则print(object[::-1])输出( )A.1B.5C.54321D.程序报错参考答案:C47. 浏览器用来记录用户状态信息的数据叫( )浏览器用来记录用户状态信息的数据叫( )A.sessionB.cookiesC.moonpiesD.selenium参考答案:B48. Python中使用下面代码打开文件也需要对文件进行close关闭操作 with open(‘文件路径’,‘文件操作方式’,encoding=‘utf-8’)as f。

)A.正确B.错误参考答案:B49. 如果使用Python的数据结构来做类比的话,MongoDB中库相当于一个大字典,大字典里面的每一个键值对都对应了一个集合,Key为集合的名字,Value就是一个( )A.字典B.集合的名字C.集合D.文档参考答案:C50. 虽然MongoDB相比于MySQL来说,速度快了很多,但是频繁读写MongoDB还是会严重拖慢程序的执行速度 )A.正确B.错误参考答案:A。